AISTAT 2020 FedPAQ: A Communication-Efficient Federated Learning Method with Periodic Averaging and Quantization

Introduction

来解决两个问题:

通信瓶颈:因为大量客户端要和中心服务器传输数据,所以在联邦学习中,通信带宽是一个主要的瓶颈。

规模:客户端在训练过程中可能是活跃的、慢速的,或者完全不活跃的。因此,一个被提出的联邦学习算法应该能够在部分设备参与或随机抽样设备的情况下高效地运行。

FedPAQ:

周期性平均:周期性平均可以减少通信轮数,从而减少训练过程的总通信成本。

部分节点参与:每一轮中,只有总设备的一小部分(即活跃设备)有助于训练模型。

量化的信息传递:节点在每轮通信中仅将其量化后的本地信息发送到服务器。

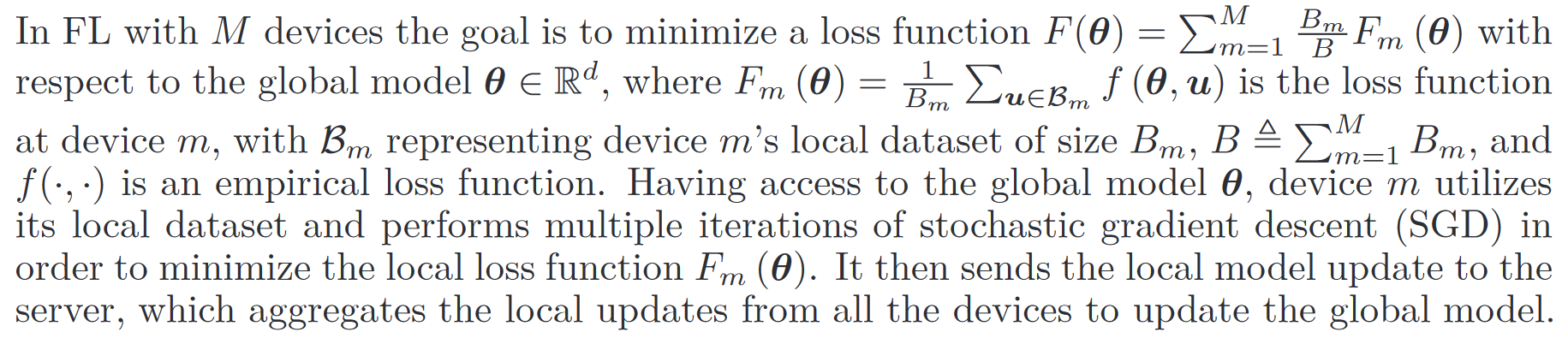

Federated Learning Setup

考虑以下随机学习问题:

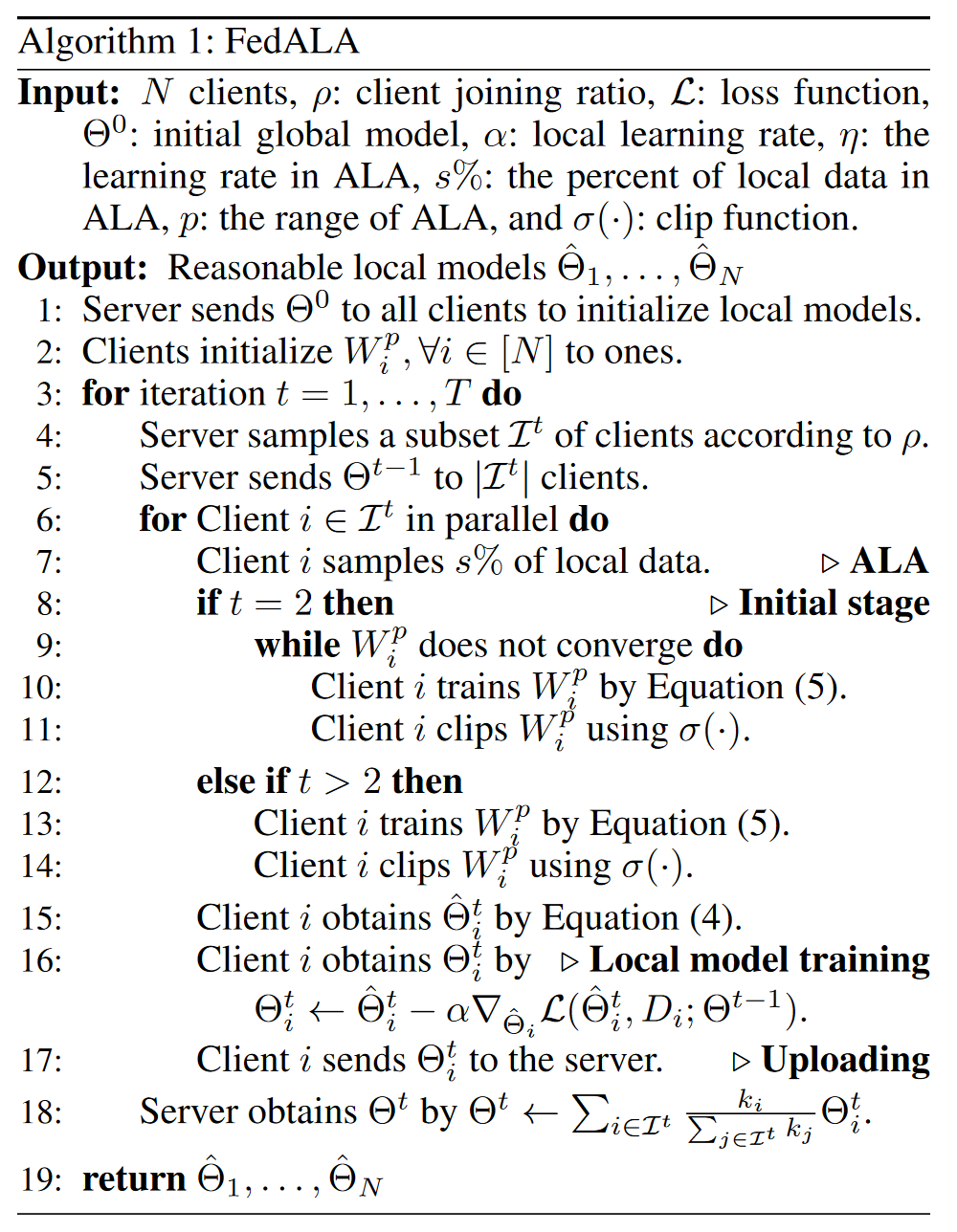

Proposed FedPAQ Method

Periodic averaging

本地运行

Partial node participation

假设在总共

在训练的每个周期里,随机选取

Quantized message-passing

上传模型时量化,用的是低精度量化器。

Algorithm update

本地更新完后,将量化更新

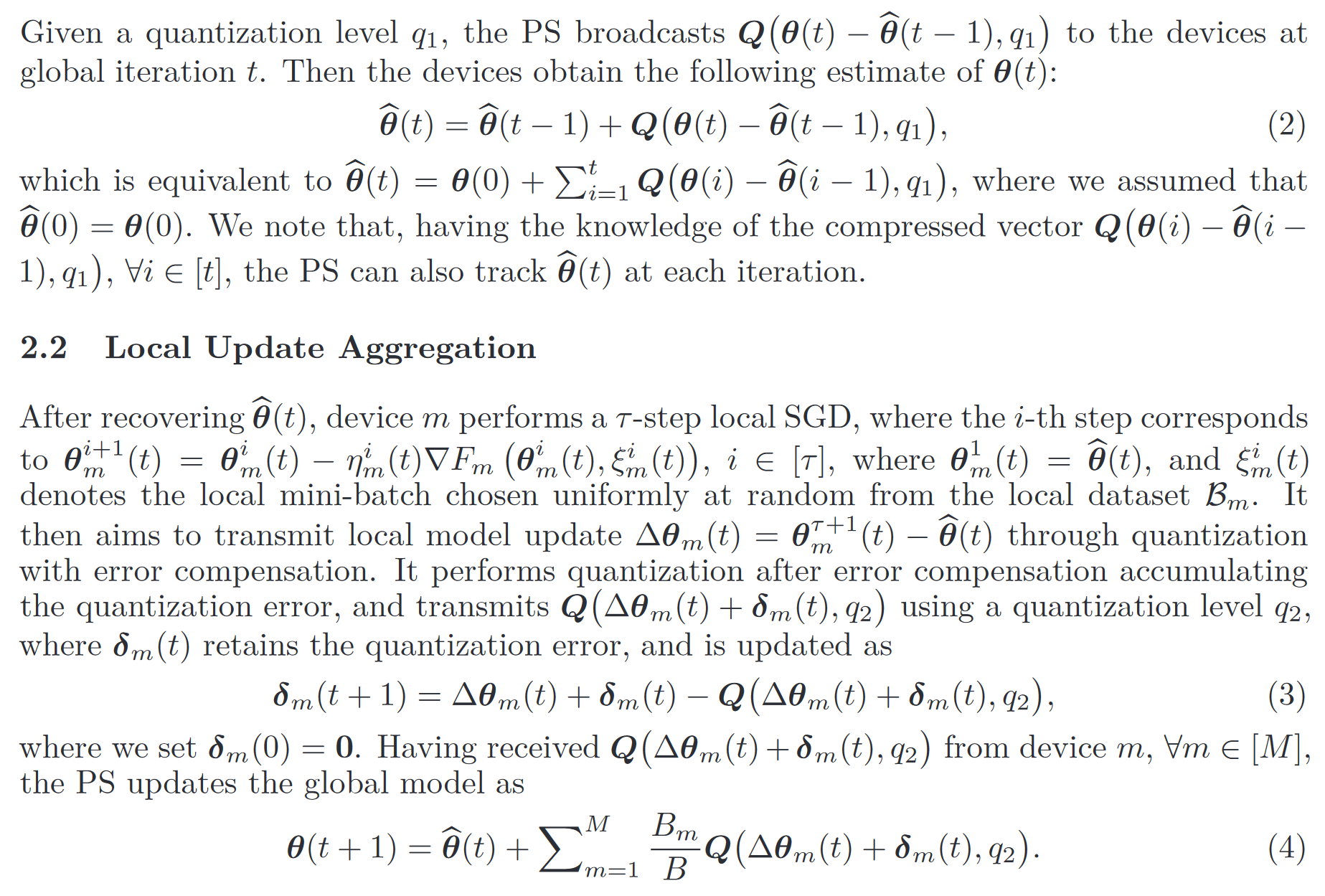

Federated Learning With Quantized Global Model Updates

Introduction

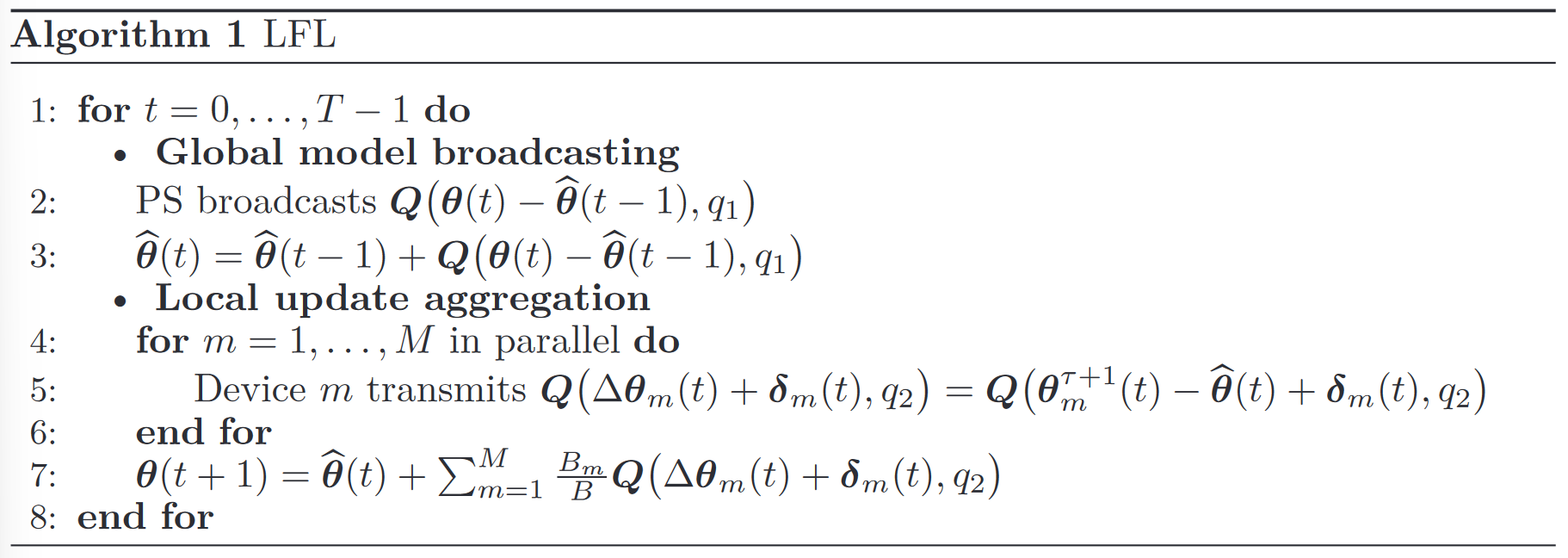

Lossy Federated Learning (LFL) Algorithm

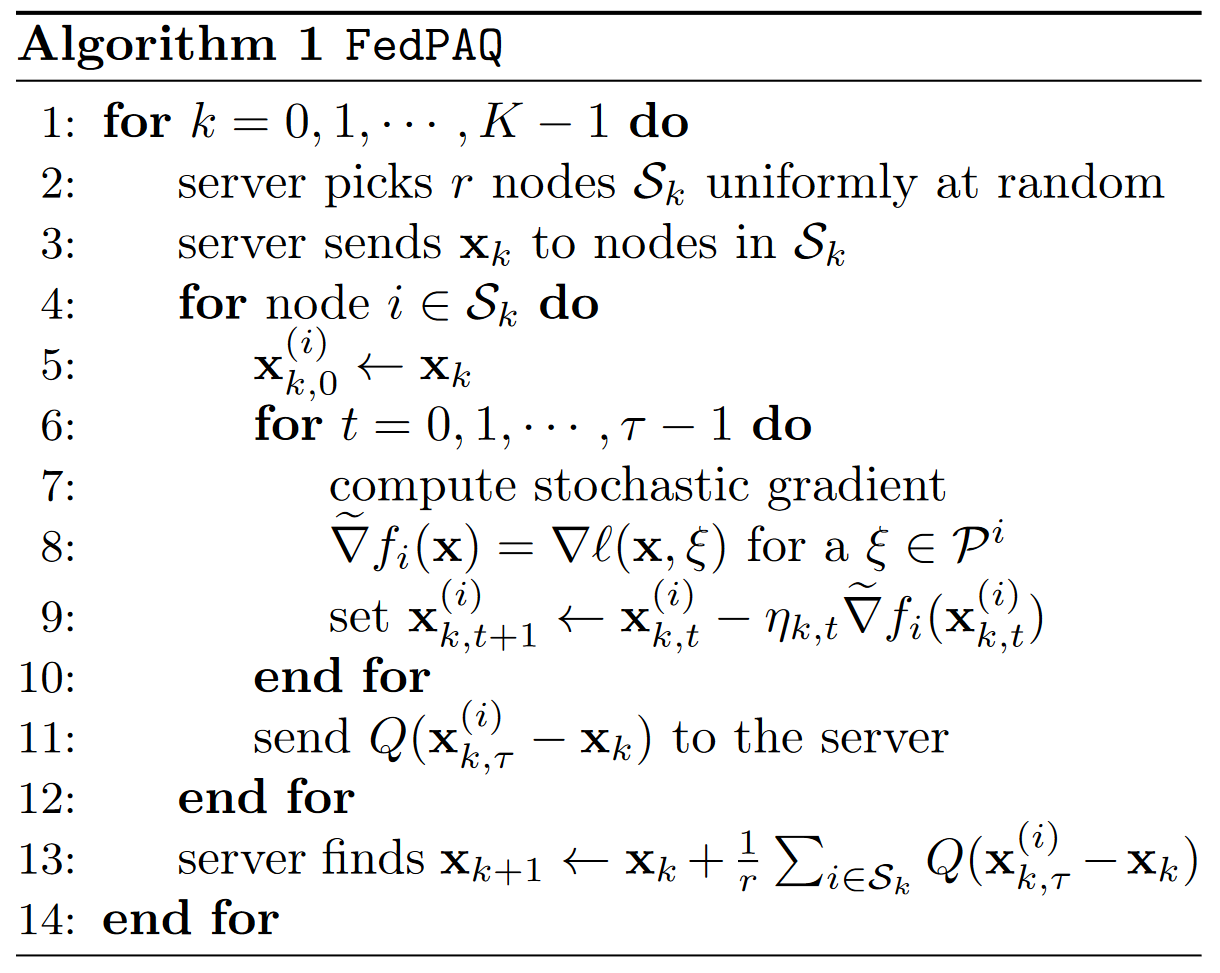

AAAI 2023 FedALA: Adaptive Local Aggregation for Personalized Federated Learning

作者对比了 11 个 SOTA 模型,并取得了超越最优方法 3.27% 的优异表现。作者将其中的自适应本地聚合模块应用到其他联邦学习方法上取得了最多 24.19% 的提升。

客户端通过 ALA 模块来对全局模型和旧的本地模型本地聚合来进行初始化,然后再训练本地模型。

在传统的联邦学习中,旧的全局模型

在 FedALA 中,聚合了全局模型和本地模型:

将

因为 DNN

中的较低层相比较高层学习了更多的一般信息,客户端希望获得全局模型较低层的大部分信息。为了减少计算开销,引入了一个超参数