联邦机器学习是一个机器学习框架,能有效帮助多个机构在满足用户隐私保护、数据安全和政府法规的要求下,进行数据使用和机器学习建模。

联邦学习白皮书:

联邦学习:在进行机器学习的过程中,各参与方可借助其他方数据进行联合建模。各方无需共享数据资源,即数据不出本地的情况下,进行数据联合训练,建立共享的机器学习模型。

横向联邦学习:

两个数据集的用户特征

在两个数据集的用户特征重叠较多而用户重叠较少的情况下,我们把数据集按照横向(即用户维度)切分并取出双方用户特征相同而用户不完全相同的那部分数据进行训练。

纵向联邦学习:

两个数据集的用户

在两个数据集的用户重叠较多而用户特征重叠较少的情况下,我们把数据集按照纵向(即特征维度)切分并取出双方用户相同而用户特征不完全相同的那部分数据进行训练。

联邦迁移学习:

两个数据集的用户

在两个数据集的用户与用户特征重叠都较少的情况下,我们不对数据进行切分,而可以利用迁移学习克服数据或标签不足的情况。

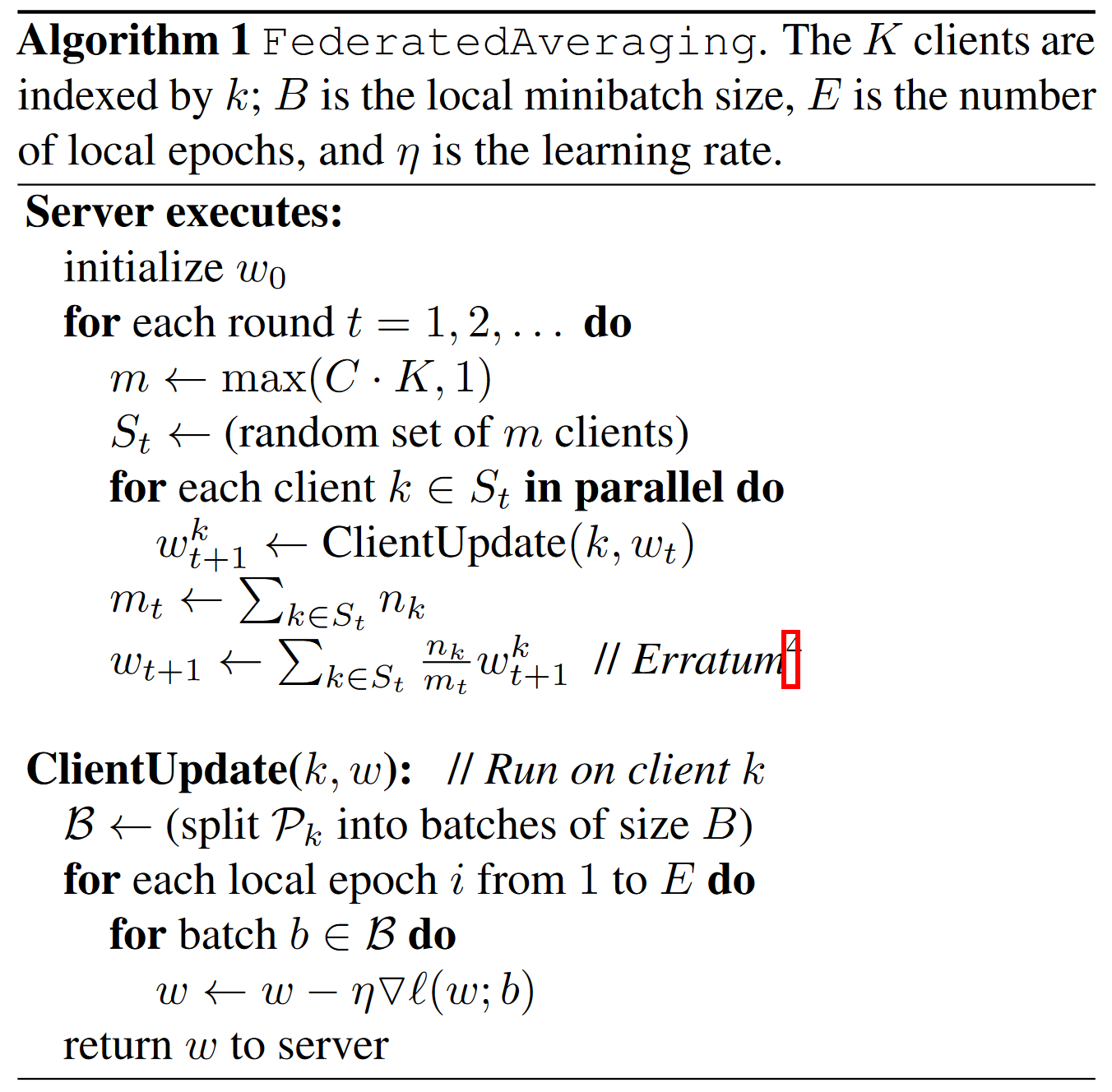

JMLR 2017 Communication-Efficient Learning Of Deep Networks From Decentralized Data

为了保证模型聚合的准确性,FedAvg 算法采用加权平均的方式进行模型聚合。设备上传的模型参数的权重是根据设备上的本地数据量大小进行赋值的,数据量越多的设备权重越大。但其也存在数据不平衡的问题,即数据量小的本地设备贡献小。

目标为:

FedAvg

进行多次迭代本地更新:

当

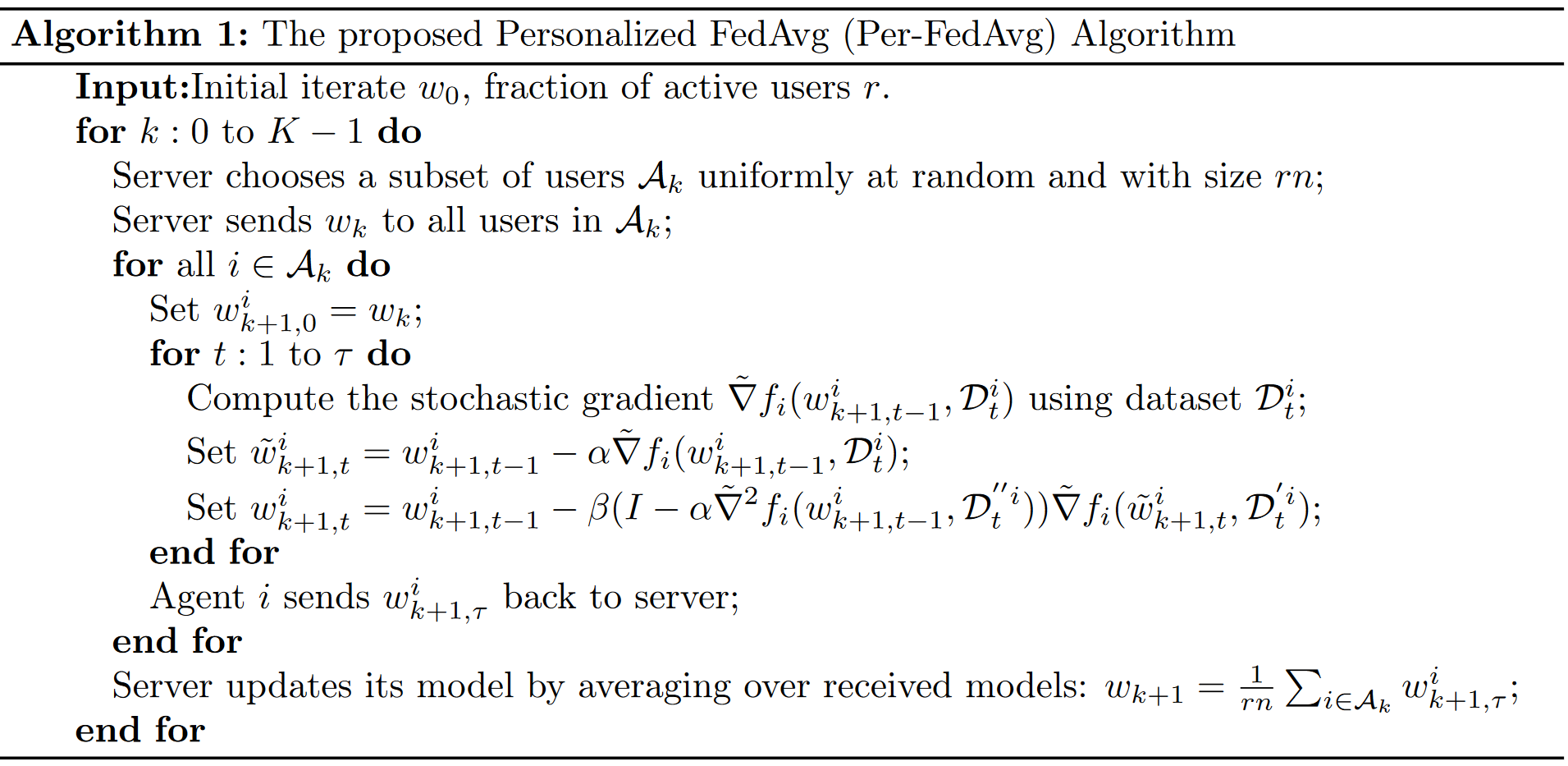

NeurIPS 2020 Personalized Federated Learning: A Meta-Learning Approach

Per-FedAvg,其目标是训练一个全局模型,该模型更容易进行微调以适应特定设备的数据。

若有

Per-FedAvg

中则是所有用户得到初始模型后,然后在本地数据上梯度下降一次来得到自己的模型:

MLSys 2020 Federated Optimization in Heterogeneous Networks

FedProx,其目标是解决在本地训练过程中,个性化模型偏离全局模型过远的问题。为了实现这一目标,FedProx 在本地训练的目标函数中引入了一个动态正则化项。这个正则化项可以限制模型的更新步骤,防止模型偏离全局模型太远。

设备

NeurIPS 2023 PRIOR: Personalized Prior for Reactivating the Information Overlooked in Federated Learning

Introduction

联邦学习的基本特性是数据异质性,导致了诸如训练和测试数据不一致(数据漂移)等挑战。

数据异质性:不同的参与者可能拥有不同类型或分布的数据。这种数据的差异性可能导致模型在不同的参与者之间表现不一致。

数据漂移:模型在训练和测试数据上的表现不一致。例如,如果模型在某一类型的数据上进行训练,但在另一类型的数据上进行测试,那么模型的表现可能会下降。这是因为模型可能未能捕捉到测试数据中的某些重要特征。

个性化 FL(PFL)被提出来减轻异构数据导致的负面影响。通过个性化学习,每个设备可以根据其自身的数据特性训练模型,从而提高模型在该设备上的性能。

现有的 PFL 存在两个问题:

相同的全局模型为本地训练提供先验知识,导致忽视客户端的采样信息。

做不到显式提取先验知识。

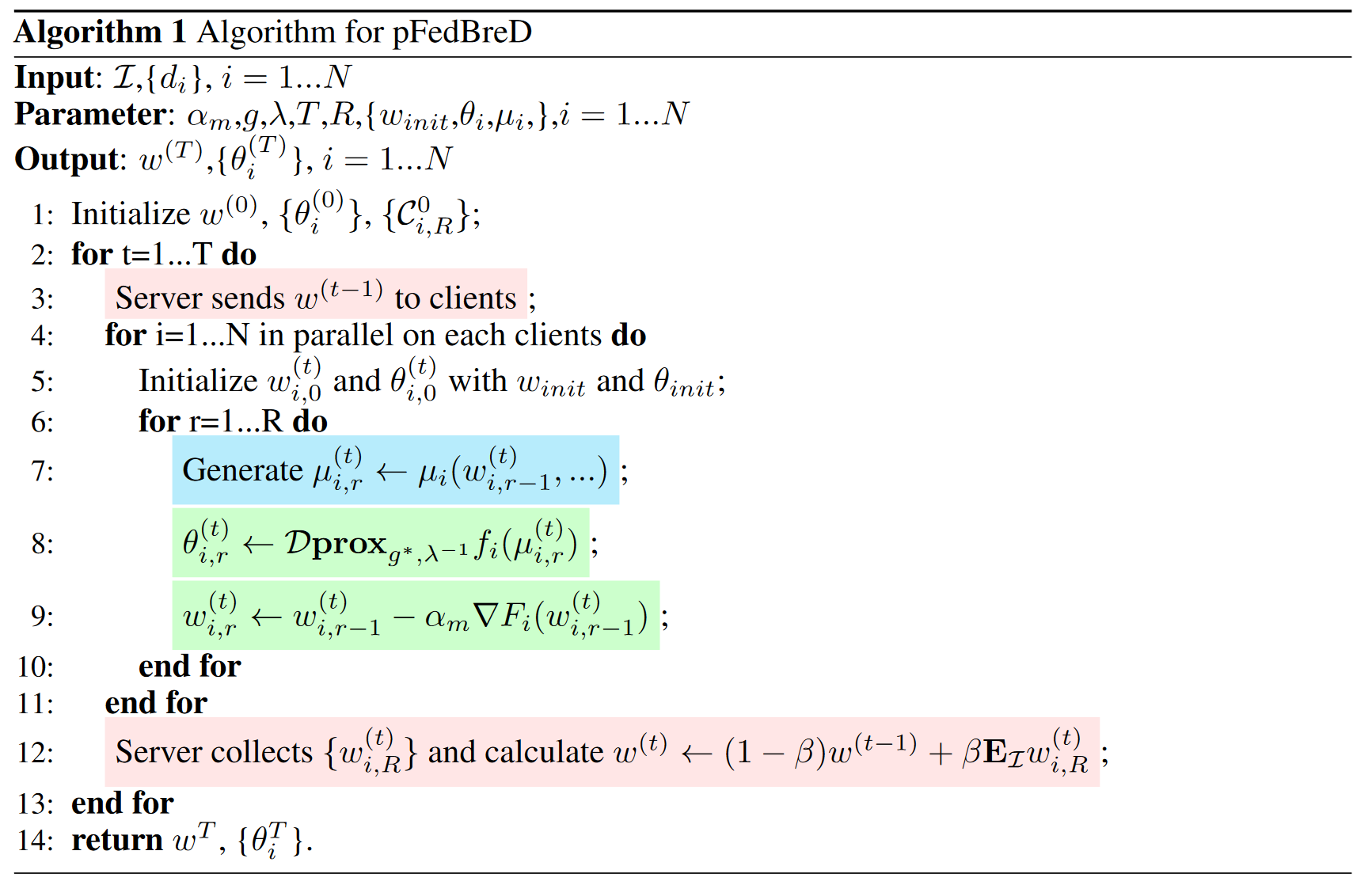

本文提出了 pFedBreD 框架,将个性化先验知识注入到全局模型提供的知识中,来解决第一个问题。引入宽松的镜像下降 RMD 来显式提取先验以探索个性化策略,来解决第二个问题。

Preliminary

Overlooked Information in Prior Knowledge

传递给客户端的全局知识与客户端采样没有互信息(Mutual

Information,MI,度量了两个变量之间相互依赖的程度),即

Bregman-Moreau Envelope

布雷格曼散度(Bregman

Divergence)是一种在优化问题中常用的正则项,它满足计算需求和先验假设:

如何理解布雷格曼散度:

为了利用布雷格曼散度的计算性质,引入布雷格曼近端映射(Bregman

proximal mapping)和布雷格曼-莫罗包络(Bregman-Moreau envelope):

Exponential Family

指数族(Exponential Family,X-family):

为了突出方差,引入了缩放指数族(Scaled Exponential

Family,SX-family):

Methodology

在经典联邦学习的基础上引入缺失的客户端采样信息,使用 EM 算法来降低引入信息的计算成本,并基于 EM 中的 E-step 提出了一类先验选择策略,RMD。

通过客户端采样

直接通过全局模型传输的先验知识作为本地训练的先验知识(例如,通过初始点,动态正则项中的惩罚点等)与客户端采样没有互信息。为了减少忽视信息的潜在影响,引入了第

Framework: Leveraging Expectation Maximization for Prior Parameter Extraction

因此用 EM 方法来近似含有未观察变量的似然函数,其中

第

Strategies: Relaxing Mirror Descent for Prior Selection

为了在封闭形式中实现 EM 的

镜像下降(Mirror Descent,简称MD)是 X-family 中的 EM,为:

Framework Design

Problem Formulation that Highlights Personalized Prior

个性化模型

Framework: pFedBreD

为了解决方程